首先可以使用下面代码来测试一下你的torch是否可以用GPU

import torch

use_gpu = torch.cuda.is_available()如果返回False那末就说明当前torch是没有使用到GPU进行加速的。

1、安装CUDA

我们首先要去NVDIA官网下载CUDA(https://developer.nvidia.com/cuda-toolkit-archive),这里根据我的系统信息选择了Windows+x86_64+win10。

注意:这里的版本选择一定要参考pytorch官网给出的版本,如果选高了可能pytorch还没支持!

安装好后进入cmd输入如下命令测试

C:\Users\jzm>nvcc -V如果得到下面类似内容则证明安装成功

nvcc: NVIDIA (R) Cuda compiler driver

Copyright (c) 2005-2021 NVIDIA Corporation

Built on Fri_Dec_17_18:28:54_Pacific_Standard_Time_2021

Cuda compilation tools, release 11.6, V11.6.55

Build cuda_11.6.r11.6/compiler.30794723_02、安装cuDNN

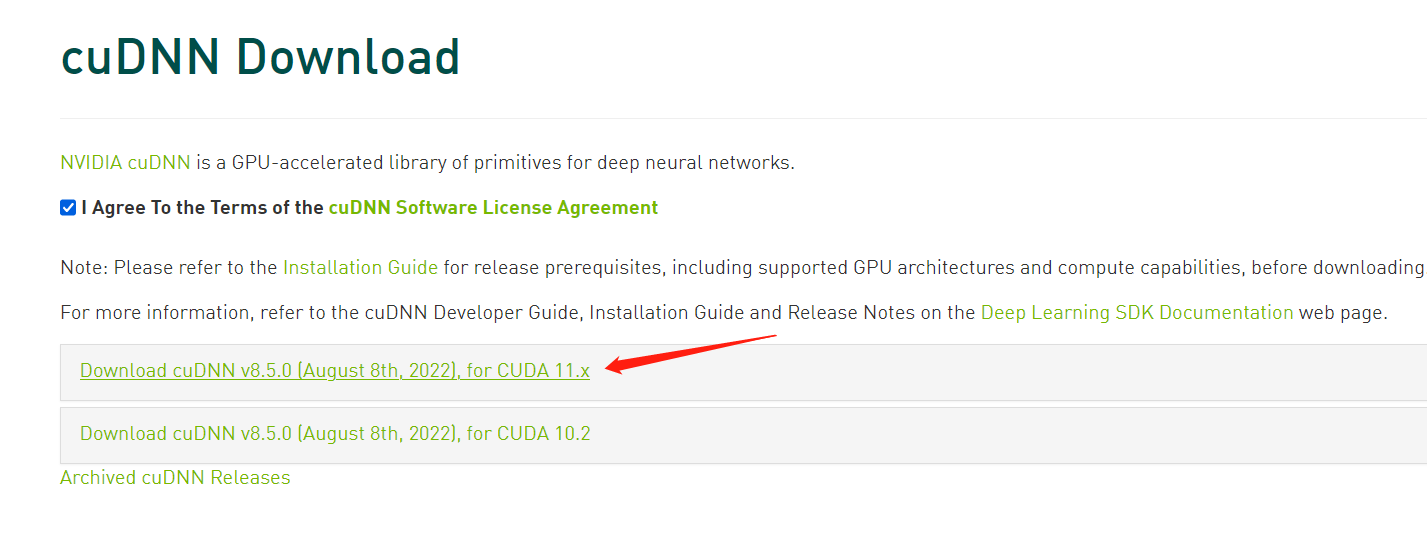

https://developer.nvidia.com/cudnn 下载对应版本的cuDNN,这里因为我的CUDA版本为11.6 所以选择如下版本

下载之后,解压缩,将cuDNN文件夹中的各自的bin、clude、lib文件夹中的内容,直接复制添加到CUDA的刚刚安装目录的对应相同名字的文件夹下。

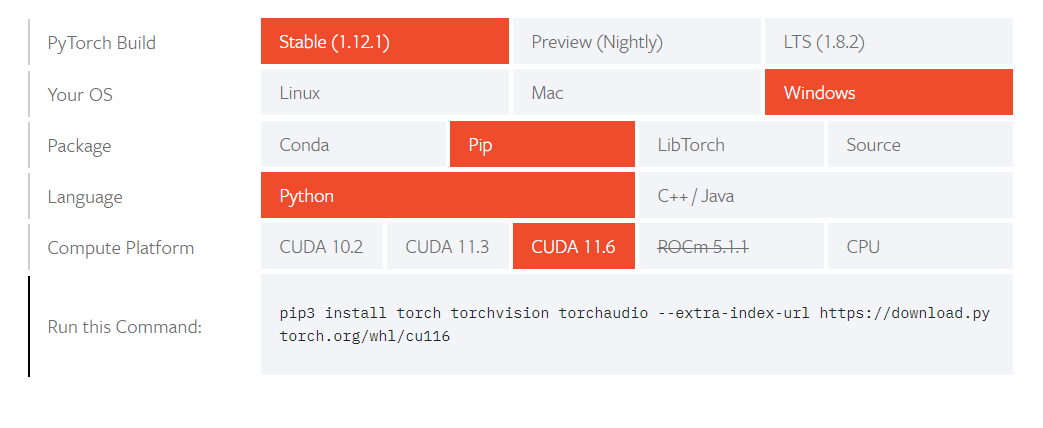

3、安装pytorch

https://pytorch.org/get-started/locally/ 选择合适的版本,我的选择如下:

复制最后一行的pip命令执行即可!

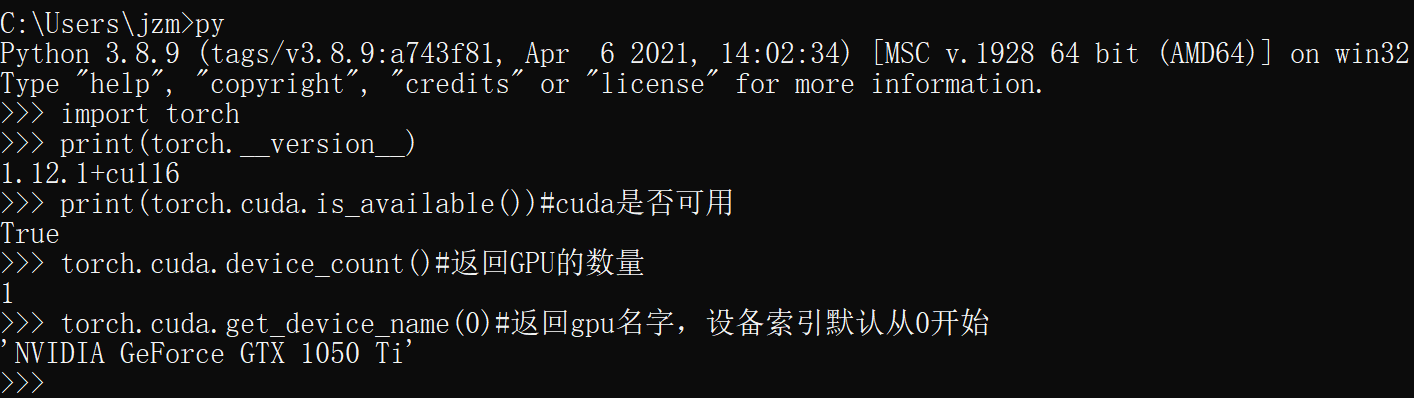

4、测试可用性

使用如下的python代码简单测试一下:

import torch

print(torch.__version__)

print(torch.cuda.is_available())#cuda是否可用

torch.cuda.device_count()#返回GPU的数量

torch.cuda.get_device_name(0)#返回gpu名字,设备索引默认从0开始

可以看到我的菜鸡GPU的一些信息,这样就可以在pytorch中愉快的调用GPU加速了。

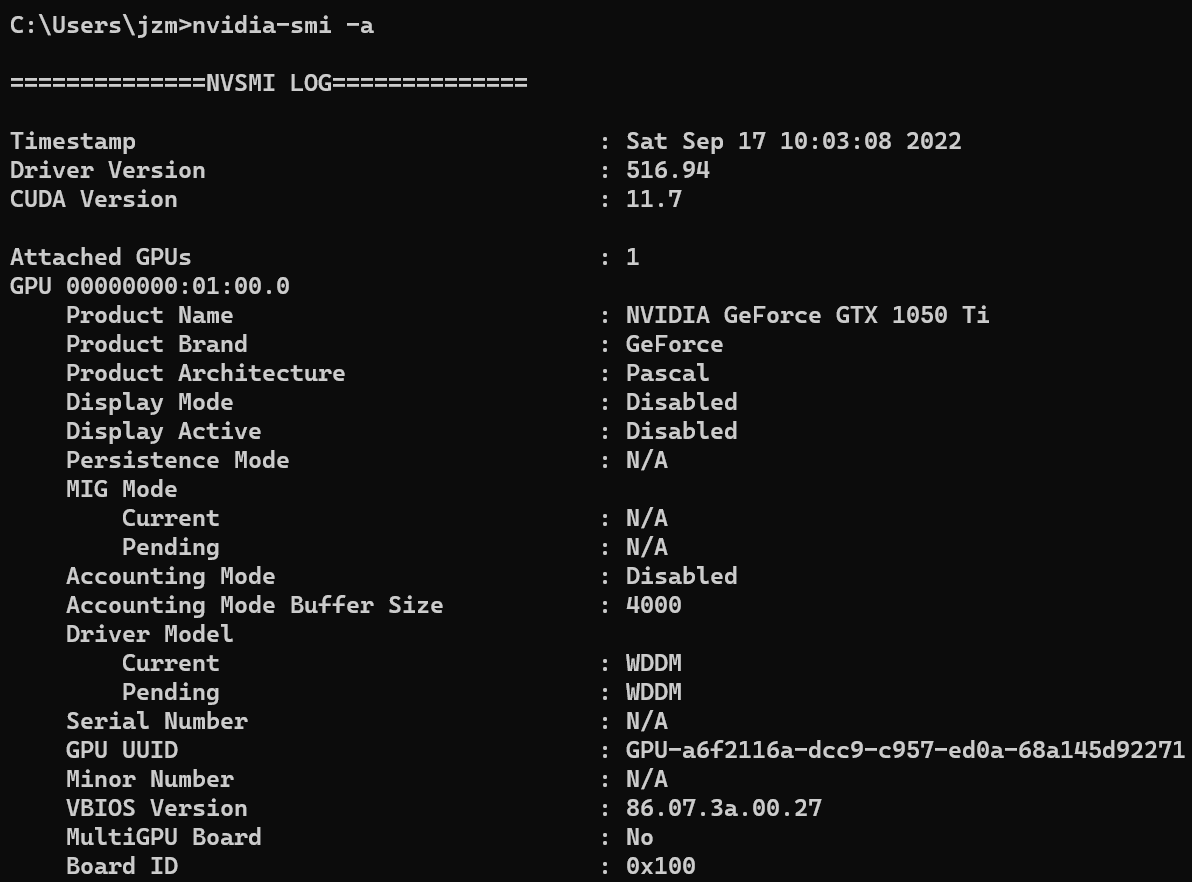

或者在cmd中使用如下命令来打印GPU相关信息

nvidia-smi -a